AIが急成長する時代において、ベトナムはFPTコーポレーションと世界有数の高性能コンピューティングソリューションプロバイダーであるNVIDIAとの戦略的協力を通じて、グローバルテクノロジーマップに強い存在感を示しています。両社は、世界最先端のAI技術であるNVIDIA H100およびNVIDIA H200スーパー チップを基盤としたエンドツーエンドのAI向け総合ソリューション「FPT AI Factory」を開発しました。

動画:FPTコーポレーション会長チュオン・ザ・ビン氏が、企業向け総合AIアプリケーション開発におけるNVIDIAとの戦略的協力について語る

政府ニュース(2024)によると、FPTコーポレーション取締役会会長兼創業者のチュオン・ザ・ビン氏は、FPTが技術研究開発力の強化を目指し、AIとクラウド基盤の先進的な製品・サービスによる総合エコシステム構築に取り組んでいることを強調しました。このエコシステムは、最先端の技術インフラ、トップレベルの専門家、各分野における深い専門知識など、すべてを網羅しています。「ベトナムをAI開発のグローバル拠点にすることを約束します。」

- NVIDIA H100 & H200スーパー チップの概要:AIコンピューティングの新たな飛躍

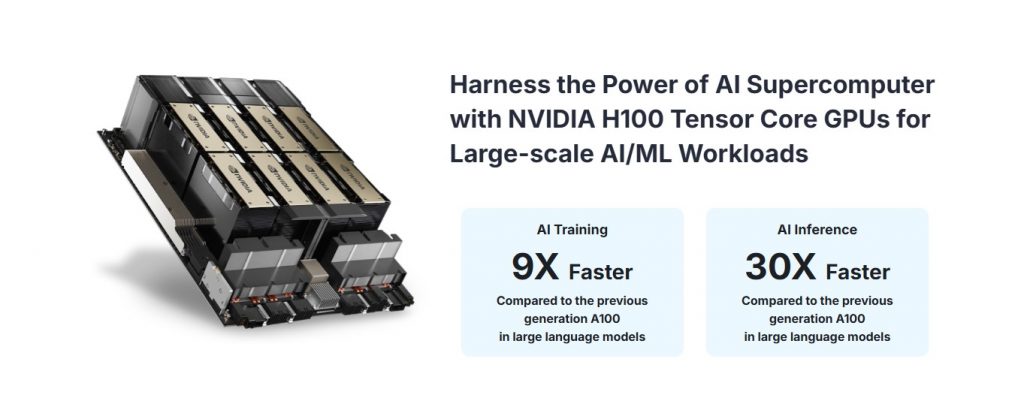

1. 1NVIDIA H100チップ(NVIDIA H100 Tensor Core GPU)について

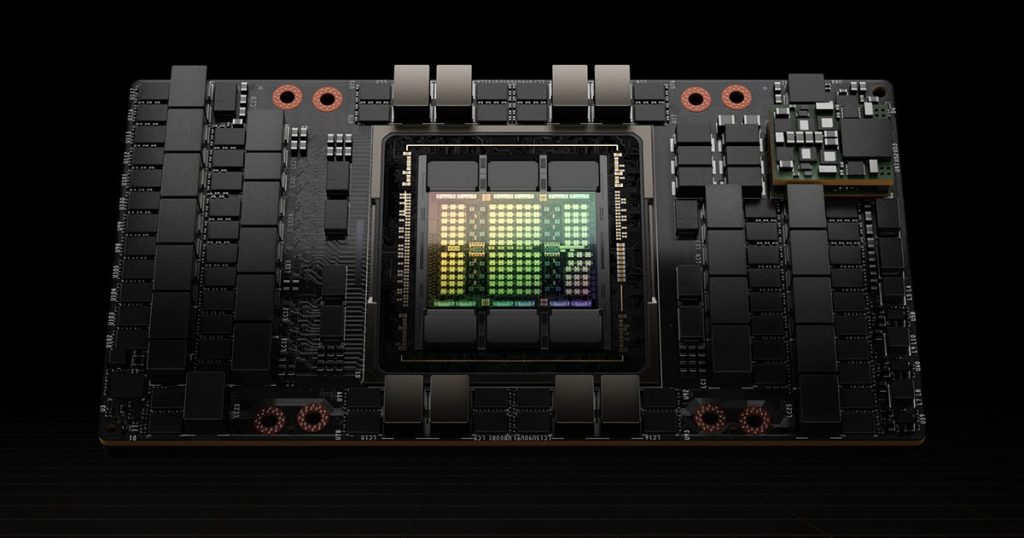

NVIDIA H100 Tensor Core GPUは、ホッパー™アーキテクチャを基盤とした革新的な設計であり、単なるグラフィックス処理チップではなく、ディープラーニングやAIアプリケーション向けに特別に最適化されています。

NVIDIA H100スーパー チップは、TSMCの先端N4プロセスを採用し、最大800億個のトランジスタを集積しています。最大144基のストリーミング・マルチプロセッサ(SM)によりAIの複雑な処理に対応します。特に、SXM5ソケットによる実装により、メモリ帯域幅が強化され、従来のPCIeソケットよりも大幅に高いパフォーマンスを発揮します。これは大規模データ処理や高速AI処理が求められる企業用途で重要なメリットです。

NVIDIAは、H100チップのフォームファクターとして「H100 SXM」と「H100 NVL」の2種類を提供しており、企業の多様なニーズに対応しています。

- H100 SXM:専用システム、スーパーコンピュータ、大規模AIデータセンター向けで、GPUのポテンシャルを最大限に引き出すNVLink拡張性が特長です。LLMやTransformer等の大規模AIモデルの学習、AI統合HPC、エクサスケール科学・バイオ・金融シミュレーション向けに最適です。

- H100 NVL:標準サーバー向けに最適化され、既存インフラへの低コスト・低複雑度での統合が可能です。リアルタイムAI推論、ビッグデータ処理、自然言語処理(NLP)、コンピュータビジョン、ハイブリッドクラウド環境でのAIアプリケーションに適しています。

| Product Specifications | H100 SXM | H100 NVL |

| FP64 | 34 teraFLOPS | 30 teraFLOP |

| FP64 Tensor Core | 67 teraFLOPS | 60 teraFLOP |

| FP32 | 67 teraFLOPS | 60 teraFLOP |

| TF32 Tensor Core* | 989 teraFLOPS | 835 teraFLOP |

| BFLOAT16 Tensor Core* | 1.979 teraFLOPS | 1.671 teraFLOPS |

| FP16 Tensor Core* | 1.979 teraFLOPS | 1.671 teraFLOPS |

| FP8 Tensor Core* | 3.958 teraFLOPS | 3.341 teraFLOPS |

| INT8 Tensor Core* | 3.958 TOPS | 3.341 TOPS |

| GPU Memory | 80GB | 94GB |

| GPU Memory Bandwidth | 3,35TB/s | 3,9TB/s |

| Decoders | 7 NVDEC

7 JPEG |

7 NVDEC

7 JPEG |

| Max Thermal Design Power (TDP) | Up to 7 MIGS @ 10GB each | 350 – 400W (adjustable) |

| Multi-Instance GPUs) | Up to 7 MIGS @ 10GB each | Up to 7 MIGS @ 12GB each |

| Form Factor | SXM | PCIe

dual-slot air-cooled |

| Interconnect | NVIDIA NVLink™: 900GB/s

PCIe Gen5: 128GB/s |

NVIDIA NVLink: 600GB/s

PCIe Gen5: 128GB/s |

| Server Options | NVIDIA HGX H100 Partner and NVIDIA-

Certified Systems™ with 4 or 8 GPUs NVIDIA DGX H100 with 8 GPUs |

Partner and NVIDIA-Certified Systems with 1 – 8 GPUs |

| NVIDIA AI Enterprise | Optional Add-on | Included |

表 1.1: H100 SXM and H100 NVLのスペック一覧

1.2 NVIDIA H200チップ(NVIDIA H200 Tensor Core GPU)について

Hopper™アーキテクチャをさらに進化させたNVIDIA H200 Tensor Core GPUは、H100の強化版として2023年11月に発表された世界最強のAIチップです。H100よりも2倍高速な処理性能を持ち、生成AIモデルやLLMなど、より大規模かつ高度なAIモデルに対応します。

H100と同様、NVIDIAはH200 Tensor Core GPUでも「H200 SXM」と「H200 NVL」の2種類を企業向けに提供しています。

- NVIDIA H200 SXM:生成AIタスクや高性能コンピューティング(HPC)向けに設計されており、膨大なデータ量の処理に最適です。専用システム、スーパーコンピュータ、大規模AIデータセンターでGPUの能力を最大限活用できます。巨大AIモデル学習、大容量メモリを必要とするHPC、エンタープライズ規模の生成AI展開に理想的です。

- NVIDIA H200 NVL:標準企業サーバー向けで既存インフラに柔軟に統合可能。スペース制約のある企業での空冷ラック設計にも適しており、あらゆる規模のAI・HPCワークロードの高速化を実現します。企業の用途としては、リアルタイムAI推論、ハイブリッドクラウド環境でのAI展開、ビッグデータ処理、NLPなどが挙げられます。

| Product Specifications | H200 SXM | H200 NVL |

| FP64 | 34 TFLOPS | 30 TFLOPS |

| FP64 Tensor Core | 67 TFLOPS | 60 TFLOPS |

| FP32 | 67 TFLOPS | 60 TFLOPS |

| TF32 Tensor Core² | 989 TFLOPS | 835 TFLOPS |

| BFLOAT16 Tensor Core² | 1.979 TFLOPS | 1.671 TFLOPS |

| FP16 Tensor Core² | 1.979 TFLOPS | 1.671 TFLOPS |

| FP8 Tensor Core² | 3.958 TFLOPS | 3.341 TFLOPS |

| INT8 Tensor Core² | 3.958 TFLOPS | 3.341 TFLOPS |

| GPU Memory | 141GB | 141GB |

| GPU Memory Bandwidth | 4,8TB/s | 4,8TB/s |

| Decoders | 7 NVDEC

7 JPEG |

7 NVDEC

7 JPEG |

| Confidential Computing | Supported | Supported |

| TDP | Up to 700W (customizable) | Up to 600W (customizable) |

| Multi-Instance GPUs | Up to 7 MIGs @18GB each | Up to 7 MIGs @16.5GB each |

| Form Factor | SXM | PCIe

Dual-slot air-cooled |

| Interconnect | NVIDIA NVLink™: 900GB/s

PCIe Gen5: 128GB/s |

2- or 4-way NVIDIA NVLink bridge:

900GB/s per GPU PCIe Gen5: 128GB/s |

| Server Options | NVIDIA HGX™ H200 partner and NVIDIA-Certified Systems™ with 4 or 8 GPUs | NVIDIA MGX™ H200 NVL partner and NVIDIA-Certified Systems with up to 8 GPUs |

| NVIDIA AI Enterprise | Add-on | Included |

表 1.2: H200 SXM and H200 NVLのスペック一覧

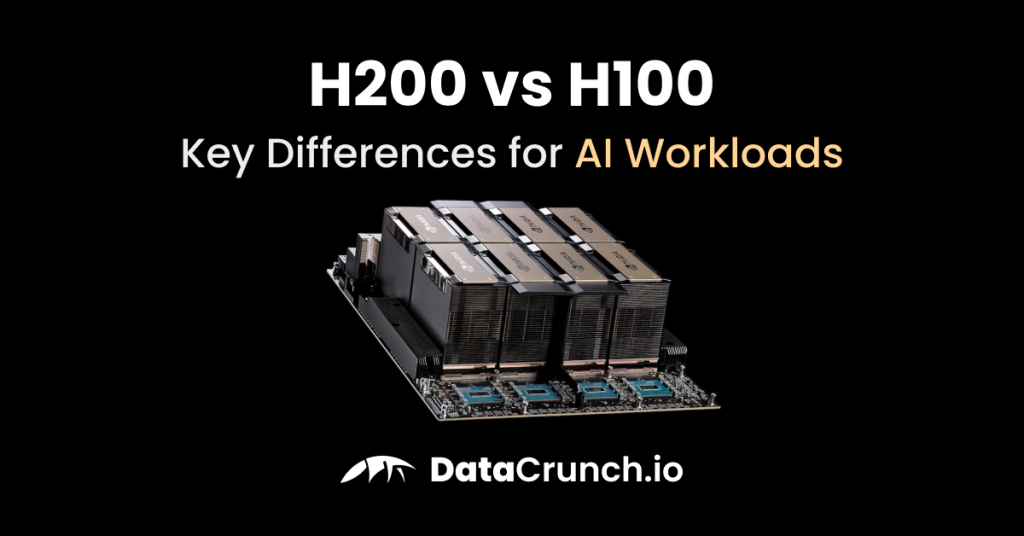

1.3 NVIDIA H100とH200スーパー チップの詳細比較

FPT Cloud提供の情報に基づき、NVIDIA H100(H100 SXM / H100 NVL)とH200(H200 SXM / H200 NVL)の詳細な比較表をご参照ください。

| Features | NVIDIA H100 (SXM) | NVIDIA H100 (NVL) | NVIDIA H200 (SXM) | NVIDIA H200 (NVL) |

| Architecture | Hopper™ | Hopper™ | Inheriting and evolving from Hopper™” | Inheriting and evolving from Hopper™” |

| Manufacturing Process | TSMC N4 (integrating 80 billion transistors) | TSMC N4 (integrating 80 billion transistors) | An upgraded version of H100 | An upgraded version of H100 |

| FP64 | 34 teraFLOPS | 30 teraFLOP | 34 TFLOPS | 30 TFLOPS |

| FP64 Tensor Core | 67 teraFLOPS | 60 teraFLOP | 67 TFLOPS | 60 TFLOPS |

| FP32 | 67 teraFLOPS | 60 teraFLOP | 67 TFLOPS | 60 TFLOPS |

| TF32 Tensor Core | 989 teraFLOPS | 835 teraFLOP | 989 TFLOPS | 835 TFLOPS |

| BFLOAT16 Tensor Core | 1.979 teraFLOPS | 1.671 teraFLOPS | 1.979 TFLOPS | 1.671 TFLOPS |

| FP16 Tensor Core | 1.979 teraFLOPS | 1.671 teraFLOPS | 1.979 TFLOPS | 1.671 TFLOPS |

| FP8 Tensor Core | 3.958 teraFLOPS | 3.341 teraFLOPS | 3.958 TFLOPS | 3.341 TFLOPS |

| INT8 Tensor Core | 3.958 TFLOPS | 3.341 TFLOPS | 3.958 TFLOPS | 3.341 TFLOPS |

| GPU Memory | 80GB | 94GB | 141GB | 141GB |

| GPU Memory Bandwidth | 3.35TB/s | 3.9TB/s | 4.8TB/s | 4.8TB/s |

| Decoders | 7 NVDEC, 7 JPEG | 7 NVDEC, 7 JPEG | 7 NVDEC, 7 JPEG | 7 NVDEC, 7 JPEG |

| Confidential Computing | No information available regarding Confidential Computing | No information available regarding Confidential Computing | Supported | Supported |

| Max Thermal Design Power – TDP | Up to 700W (user-configurable) | 350 – 400W (configurable) | Up to 700W (user-configurable) | Up to 600W (customizable) |

| Multi-Instance GPUs | Up to 7 Multi-Instance GPU (MIG) partitions, each with 10GB | Up to 7 Multi-Instance GPU (MIG) partitions, each with 12GB | Up to 7 Multi-Instance GPU (MIG) partitions, each with 18GB | Up to 7 Multi-Instance GPU (MIG) partitions, each with 16.5GB |

| Form Factor | SXM | PCIe interface, with a dual-slot, air-cooled design | SXM | PCIe interface, with a dual-slot, air-cooled design |

| Interconnect | NVIDIA NVLink™: 900GB/s;; PCIe Gen5: 128GB/s | NVIDIA NVLink: 600GB/s;; PCIe Gen5: 128GB/s | NVIDIA NVLink™: 900GB/s; PCIe Gen5: 128GB/s | NVIDIA NVLink 2- or 4-way bridge: 900GB/s per GPU; PCIe Gen5: 128GB/s |

| Server Options | NVIDIA HGX H100 Partner and NVIDIA-Certified Systems™ with 4 or 8 GPUs; NVIDIA DGX H100 with 8 GPUs | Compatible with Partner and NVIDIA-Certified Systems supporting 1 to 8 GPUs | Supported on NVIDIA HGX™ H200 Partner Systems and NVIDIA-Certified Platforms featuring 4 or 8 GPUs | NVIDIA MGX™ H200 NVL Partner & NVIDIA-Certified Systems (up to 8 GPUs) |

| NVIDIA AI Enterprise | Add-on | Included | Add-on | Included |

表 1.3: NVIDIA H100(SXM・NVL)とNVIDIA H200(SXM・NVL)の詳細比較表

2. FPT、NVIDIAと戦略的提携しベトナム初のAI Factoryを開発

NVIDIAの先進技術と、FPTの企業向けソリューション展開の豊富な経験が融合し、ベトナム市場向けの革新的AI製品開発で強力なアライアンスが誕生しました。NVIDIAは最先端のH100・H200 GPUスーパー チップを供給するだけでなく、AIアーキテクチャの深い専門知識も共有します。FPTコーポレーションでは、FPT Smart CloudがこのAI Factory基盤によるクラウドコンピューティング・AIサービスを先駆的に提供し、ベトナム企業やスタートアップがAIの力を容易に活用できるようにします。

特に、FPTは生成AIモデルの開発に注力し、コンテンツ生成、プロセス自動化、従来難しかった複雑な課題解決などの機能を提供します。

AI技術が急成長する時代、金融、証券、保険、製造、教育など全業界のB2B企業は、デジタル変革の突破口となる信頼できるパートナーを求めています。FPT CloudのFPT AI Factoryは、以下の優れたメリットで最適なソリューションとなります。

- 最先端AIインフラ:NVIDIA H100・H200スーパー チップを直接活用し、全AIタスクにおいて卓越した性能とスピードを提供します。

- 多様なサービスエコシステム:FPT AI Factoryはハードウェアに留まらず、開発・学習・展開までAIソリューションライフサイクルを全面支援する総合エコシステムです。

- コスト最適化:複雑なAIインフラへの数百万ドル投資を必要とせず、クラウドサービスとして利用することで初期投資・運用コストの最適化が可能です。

- セキュリティ・コンプライアンス・統合性:FPTは国際的なセキュリティ基準を満たした安全なAI環境を提供し、既存企業システムとのシームレス統合も実現します。

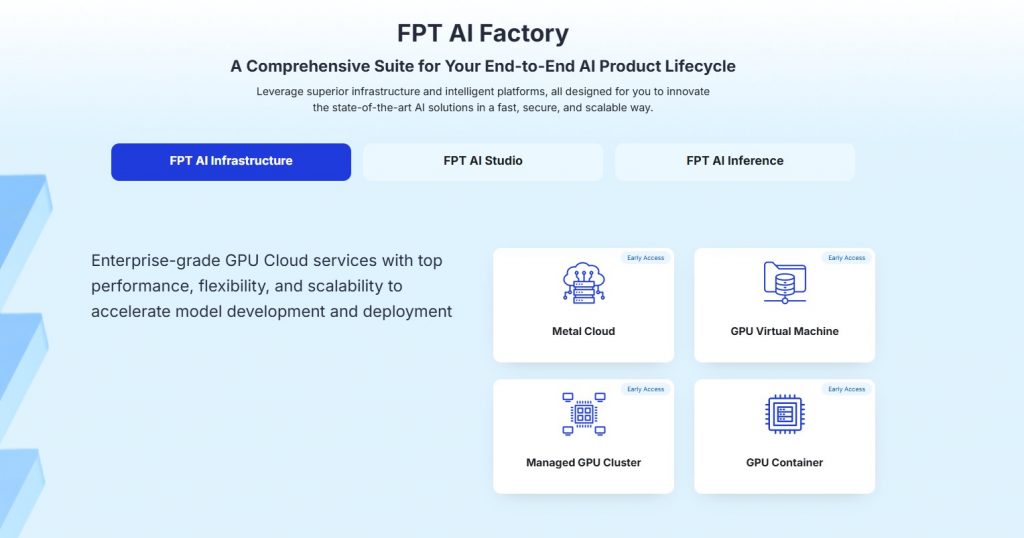

3. NVIDIA H100・H200スーパー チップを核としたFPT AI Factoryエコシステム構築

(FPT AI Infrastructure、FPT AI Studio、FPT AI Inference)

FPT AI Factoryは、NVIDIA H100・H200スーパー チップを基盤に、企業向けに以下の3つのAIソリューションを提供しています。

- FPT AI Infrastructure:企業インフラ関連製品群

- FPT AI Studio:企業向けツール・サービス基盤製品群

- FPT AI Inference:企業向けAI・機械学習モデルの運用基盤製品群

動画:FPTの3つのAIソリューション(AI Infrastructure、AI Studio、AI Inference)で、企業はAIソリューションの構築・学習・運用を簡単かつ効果的に実現できます。

3.1 FPT AI Infrastructureソリューション

FPT AI Infrastructureは、AIワークロードに特化した堅牢なクラウドコンピューティングインフラであり、NVIDIA H100・H200 GPUによる優れた計算能力を提供します。企業はスーパーコンピューティングインフラを構築し、AIモデルの迅速な学習・利用・拡張をMeta Cloud、GPU仮想マシン、Managed CPU Cluster、GPUコンテナなどの技術で柔軟に実現できます。

今すぐFPT AI Infrastructureに登録して、企業向け強力なインフラを構築・開発しましょう!

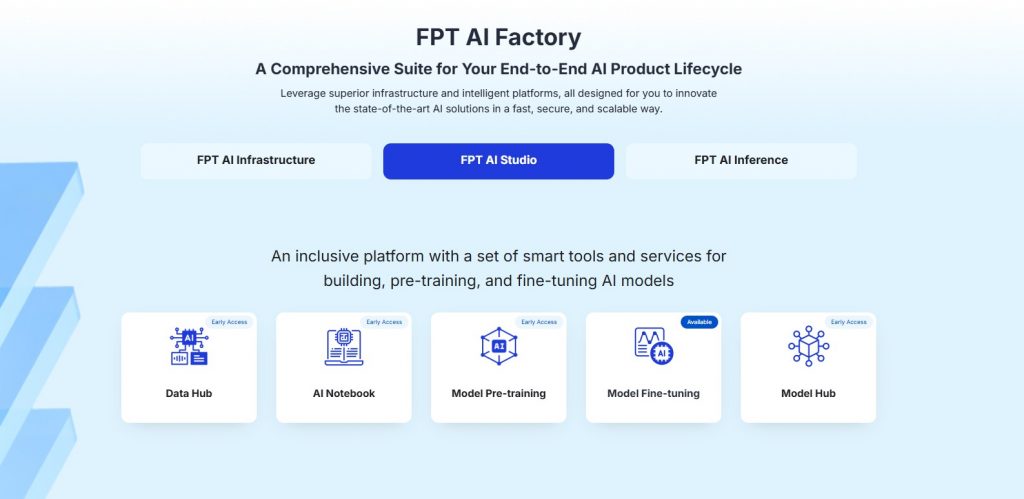

3.2 FPT AI Studio製品

先進GPU技術によるインフラを構築した企業は、次のステップとして自社の運用・用途に合わせたAI/機械学習モデルを開発する必要があります。FPT AI Studioはその最適解です。データ処理、モデル開発、学習、評価、実運用展開まで一貫して支援する包括的なAI開発環境であり、Data Hub、AI Notebook、モデル事前学習、微調整、Model Hubなど最先端技術を活用できます。

今すぐ登録して、企業向けAI・機械学習モデルの構築・展開を始めましょう!

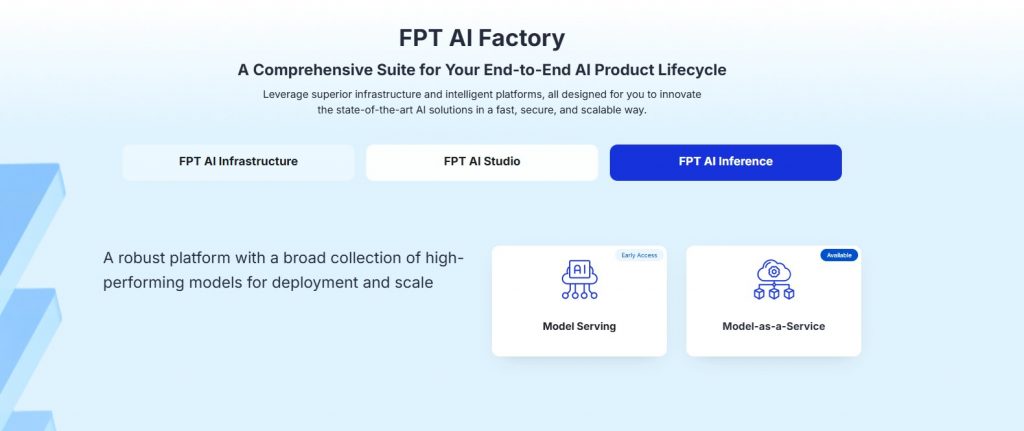

3.3 FPT AI Inferenceサービス

企業のAI/機械学習モデルを内部データや重要データで学習した後、実環境で展開・運用するには効率的なソリューションが必要です。FPT AI Inferenceはその知的な選択肢です。高い推論速度と低遅延で最適化されており、バーチャルアシスタント、顧客相談、レコメンデーション、画像認識、自然言語処理など実運用でAIモデルが迅速・正確に機能します。Model ServingやModel-as-a-Serviceなど先端技術によって実現されています。FPT AI Factoryソリューション群の最終ピースとして、企業のAI実装・即時価値創出を支援します。

FPT AI Inferenceで企業AIモデルの推論能力と実運用価値を今すぐ高めましょう!

FPT AI Factoryの詳細はこちら:https://fptcloud.com/ja/product/fpt-ai-factory-ja/

ホットライン:0800-300-9739

メール:support@fptcloud.jp